El archivo robots.txt de WordPress juega un papel importante en el ranking de los motores de búsqueda.

Ayuda a indexar y rastrear partes importantes de nuestro blog y funciona como un mapa de ruta para los motores de búsqueda.

Sin embargo, un archivo Robots.txt configurado incorrectamente puede alejarte por completo de los motores de búsqueda. Por lo tanto, es importante que cuando realices cambios en tu archivo robots.txt, esté bien optimizado y no bloquee el acceso a partes importantes de tu blog.

Cualquier persona con conocimientos básicos puede crear y editar un archivo Robots.txt y, si eres nuevo en esto, esta publicación es perfecta para tu necesidad.

Contenido del artículo

La mayoría de los webmasters tienden a evitar editar el archivo Robots.txt, pero no es tan difícil optimizarlo adecuadamente.

Como sabemos, las prácticas SEO tienen cientos de criterios y uno de los claves es el archivo Robots.txt. Este pequeño archivo de texto que se encuentra en la raíz de tu sitio web puede ayudar a optimizarlo.

Sin embargo, también existen malentendidos con respecto a la indexación y la no indexación del contenido en Robots.txt, por lo que también analizaremos ese aspecto.

Si tu sitio web no tiene un archivo Robots.txt, puedes aprender cómo hacerlo aquí.

Si tu blog / sitio web tiene un archivo Robots.txt pero no está optimizado, puedes seguir esta publicación y optimizar tu archivo Robots.txt.

El archivo Robots.txt ayuda a los robots del motor de búsqueda y direcciona a qué parte rastrear y qué parte evitar. Cuando un robot de búsqueda o una araña del motor de búsqueda llega a tu sitio y quiere indexarlo, primero siguen el archivo Robots.txt.

El bot de búsqueda o araña sigue las instrucciones del archivo para indexar o no indexar páginas de tu sitio web.

Si usas WordPress, encontrarás el archivo Robots.txt en la raíz de tu instalación.

Para sitios web estáticos, si tú o tus desarrolladores han creado uno, lo encontrarás en tu carpeta raíz.

Si no puedes, simplemente crea un nuevo archivo de bloc de notas, nómbralo Robots.txt y cárgalo en el directorio raíz de tu dominio utilizando el FTP.

Como ejemplo, aquí está nuestro archivo de Neetwork, donde puedes ver el contenido y es la ubicación en la raíz del dominio.

https://www.shoutmeloud.com/robots.txt

Como mencionamos anteriormente, Robots.txt es un archivo de texto general. Por lo tanto, si no tienes este archivo en tu sitio web, abre cualquier editor de texto que desees (Bloc de notas, por ejemplo) y crea un archivo Robots.txt creado con uno o más registros.

Cada registro contiene información importante para el motor de búsqueda. Ejemplo:

Usuario-agente: googlebot

Disallow: /cgi-bin

Si estas líneas están escritas en el archivo Robots.txt, significa que le permite al bot de Google indexar cada página de tu sitio.

Pero la carpeta cgi-bin del directorio raíz no permite la indexación. Eso significa que Google bot no indexará la carpeta cgi-bin.

Al utilizar la opción Rechazar, puedes restringir cualquier bot de búsqueda o araña de la indexación de una página o carpeta.

Hay muchos sitios que no usan índices en la carpeta o página del archivo para no crear contenido duplicado.

Puedes obtenerlo en el registro de tu sitio web, pero si quieres muchos visitantes del motor de búsqueda, debes permitir cada bot de búsqueda.

Eso significa que cada bot de búsqueda indexará tu sitio.

Puedes escribir User-agent: * para permitir cada bot de búsqueda.

Por ejemplo:

User-agent: * Disallow: /cgi-bin

Es por eso, que cada bot de búsqueda indexará tu sitio web.

Ejemplo:

Mala práctica:

user-agent: *

Dis allow: /supportBuena práctica:

User-agent: *

Disallow: /support

Mala práctica:

Disallow: /support

User-agent: *

Buena práctica:

User-agent: *

Disallow: /support

Mala práctica:

User-agent: *

disallow: /support /cgi-bin /images /

Buena práctica:

User-agent: *

disallow: /support

disallow: /cgi-bin

disallow: /images

User-agent: *

Disallow:

User-agent: *

Disallow: /

Después de editar el archivo, cárgalo a través de cualquier software FTP en Root o Home Directory de tu sitio.

Puedes editar tu archivo Robots.txt de WordPress iniciando sesión en tu cuenta FTP del servidor o puedes usar plugins como Robots meta para editar el archivo desde el panel de WordPress.

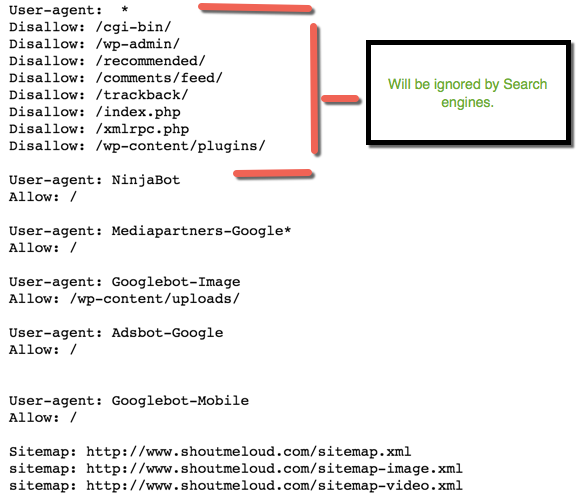

Hay algunas cosas que debes agregar en tu archivo junto con tu URL del mapa del sitio. Agregar la URL del mapa del sitio ayuda a los robots de los motores de búsqueda a encontrar tu archivo de mapa del sitio y los resultados en una indexación más rápida de las páginas.

Aquí hay una muestra del archivo Robots.txt para cualquier dominio.

En el mapa del sitio, reemplaza la URL con la de tu blog:

mapa del sitio: https://www.neetwork.com/sitemap.xml

User-agent: *

# disallow all files in these directories

Disallow: /cgi-bin/

Disallow: /wp-admin/

Disallow: /archives/

disallow: /*?*

Disallow: *?replytocom

Disallow: /comments/feed/

User-agent: Mediapartners-Google*

Allow: /

User-agent: Googlebot-Image

Allow: /wp-content/uploads/

User-agent: Adsbot-Google

Allow: /

User-agent: Googlebot-Mobile

Allow: /

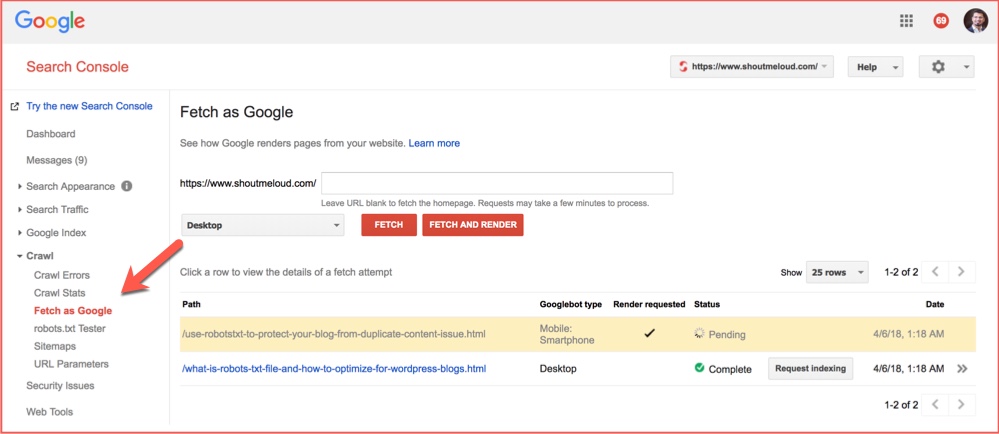

Ahora has realizado algunos cambios en tu archivo Robots.txt, y es hora de comprobar si tu contenido se ve afectado por la actualización.

Puedes usar la herramienta de búsqueda de Google 'Buscar como herramienta de Google' para ver si tu contenido puede ser accedido por el archivo nuevo que has creado o modificado.

Estos pasos son simples:

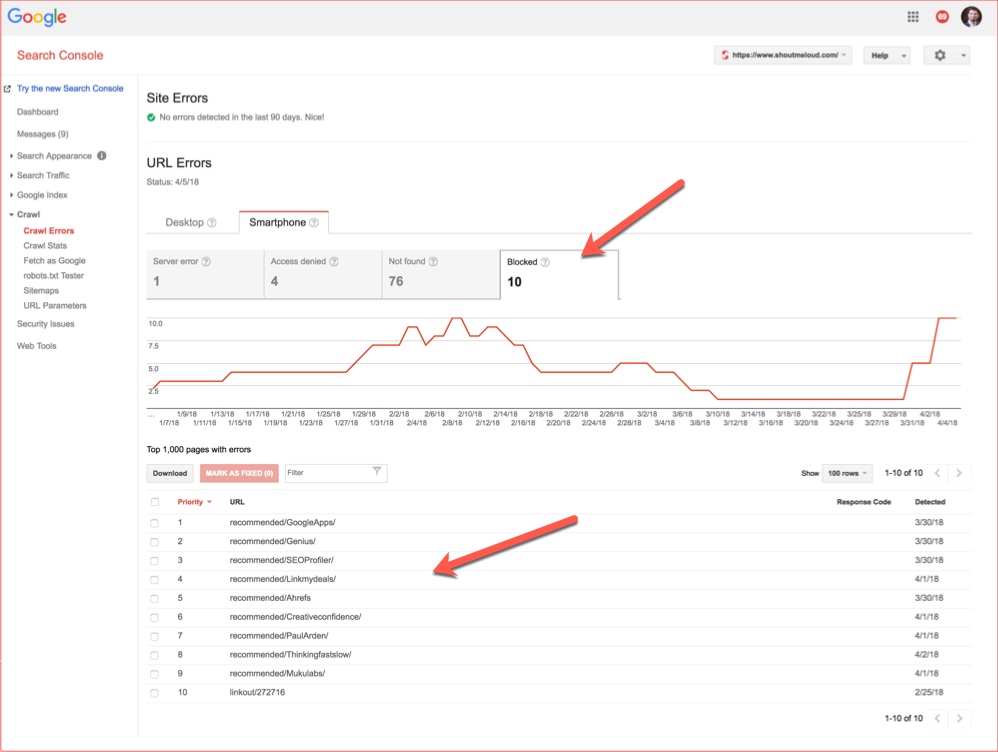

También, puedes verificar los errores de rastreo en la sección Error de rastreo de la consola de búsqueda.

En Rastrear> Rastrear error, selecciona Restringido por Robots.txt y verás que todos los enlaces han sido negados por tu archivo.

Aquí hay un ejemplo de un error de rastreo para Neetwork:

Puedes ver claramente que los enlaces de Replytocom han sido rechazados por Robots.txt y también otros enlaces que no deberían formar parte de Google.

¿Utilizas WordPress Robots.txt para optimizar tu sitio? ¿Deseas agregar más información a tu archivo?

Coméntanos.